根據 Attention Is All You Need 論文,節錄並了解其訓練模型細節,作為自行訓練模型時的參考。

使用標準 WMT 2014 英語-德語資料集進行訓練,該資料集包含約 450 萬個數據句子對。句子使用位元組對編碼進行編碼,目標詞彙量約37000個。 至於英語-法語,使用了更大的 WMT 2014年英語-法語資料集,由 3600 萬個句子組成,並將標記拆分為 32000 個單字片段詞彙。句子對按大致序列長度分批在一起。 每次訓練批次包含一組句子對,其中包含大約 25000 個來源標記和 25000 個目標token。

配備 8 個 NVIDIA P100 GPU 訓練模型。 對於我們的基本模型使用根據整篇論文描述的超參數,每個訓練步驟大約需要 0.4 秒。我們對基礎模型進行了總計 100,000 步或 12 小時的訓練。 對於我們的大模型,步驟時間為 1.0 秒。 大模型接受了 30 萬步的訓練(3.5 天)。

訓練期間採用三種類型的正規化:

*Illia Polosukhin, “Attention Is All You Need”, 31st Conference on Neural Information Processing Systems (NIPS 2017), Long Beach, CA, USA.

將 dropout應用於每個子層的輸出,然後將其新增至子層輸入並標準化。 此外將 dropout 應用於嵌入和編碼器和解碼器堆疊中的位置編碼,使用的速率為Pdrop = 0.1。

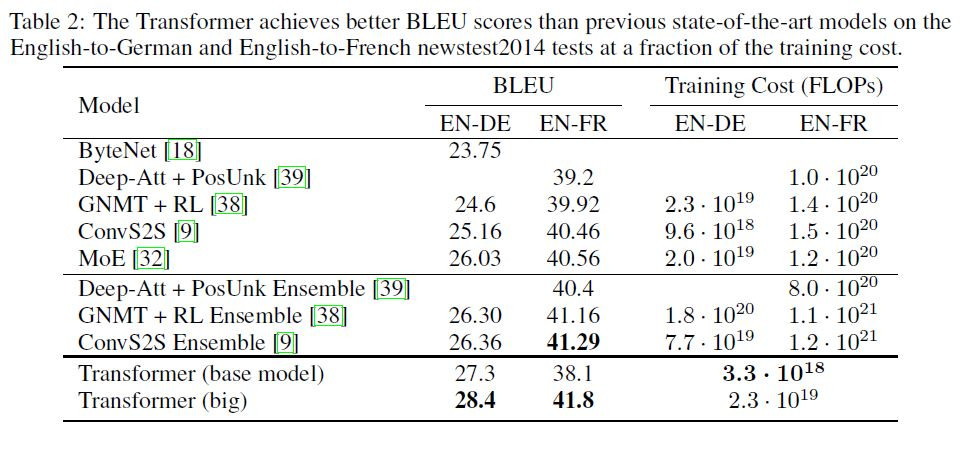

在訓練過程中採用了 ϵls = 0.1 的標籤平滑。 這會損害困惑度,因為模型會變得更加不確定,但會提高準確性和 BLEU 分數。